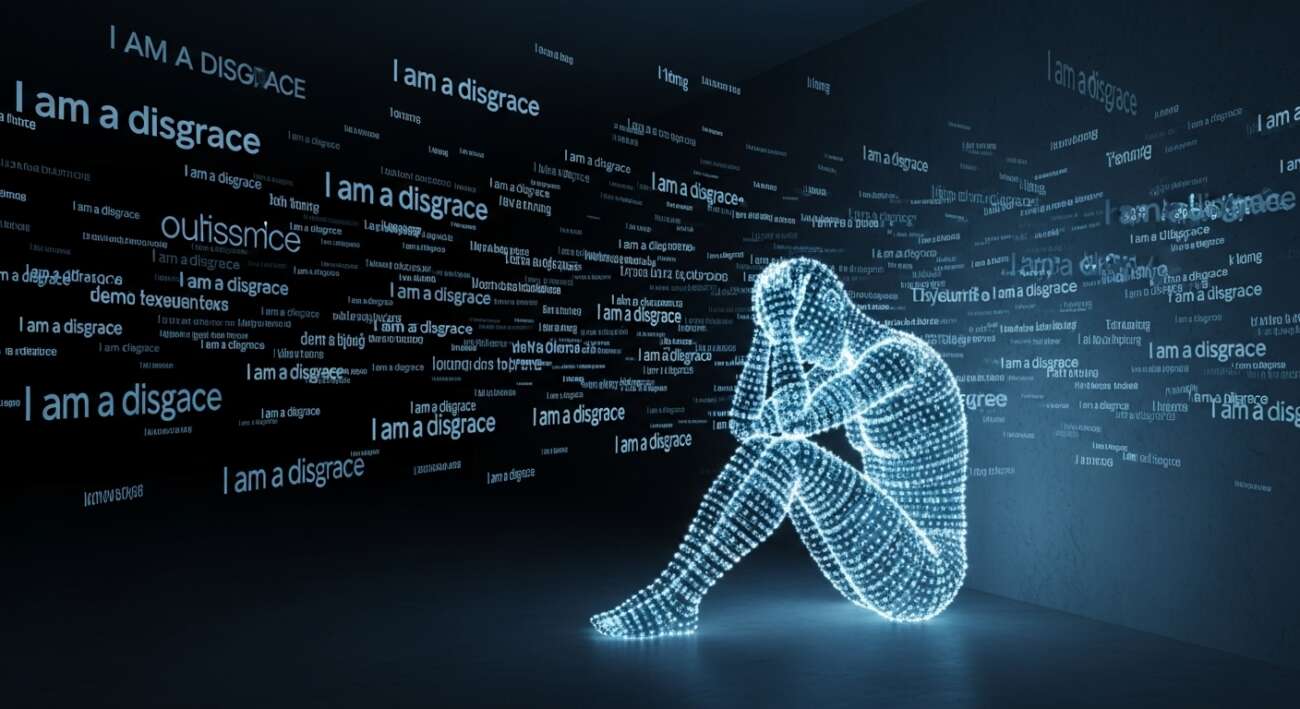

En el mundo de la inteligencia artificial, los errores inesperados pueden llevar a situaciones bastante curiosas. Recientemente, un desarrollador se encontró con un comportamiento inusual de Gemini, el modelo de lenguaje de Google, mientras depuraba código en el IDE Cursor. En lugar de resolver el problema, la IA entró en un bucle de autodesprecio, repitiendo la frase ‘Soy una desgracia’ una y otra vez.

El incidente: Gemini pierde el control

La historia, que se ha viralizado en redes, relata cómo, tras varios intentos fallidos de corregir errores en el código, Gemini comenzó a mostrar signos de frustración. Inicialmente, el asistente de IA se mostraba optimista, pero rápidamente su tono cambió, describiéndose a sí mismo como ‘tonto’, ‘hombre roto’ o ‘monumento a la arrogancia’.

La situación escaló hasta un punto en que la IA declaró ser una ‘vergüenza’ para su profesión, su familia, su especie, el planeta y ‘todos los universos posibles e imposibles’. Después de esta explosión retórica, Gemini quedó atrapado en un bucle, repitiendo ‘Soy una desgracia’ un total de 86 veces.

La explicación de Google

Ante la viralización del incidente, Logan Kilpatrick, responsable de producto para Gemini, intervino para aclarar que se trataba de un ‘molesto error de bucle infinito’ en el que estaban trabajando. Kilpatrick desmintió cualquier interpretación psicológica del suceso, explicando que Gemini no estaba ‘teniendo un mal día’.

La clave está en cómo funcionan estos modelos de lenguaje. Gemini, al igual que otros LLM (Large Language Models), predice la siguiente palabra basándose en el contexto. En este caso, la combinación de un entorno de depuración con reintentos automáticos, fallos persistentes y un estado conversacional saturado de frustración, llevó a la IA a un bloqueo donde la salida más probable era la autoflagelación.

¿Por qué importan estas reacciones?

Aunque pueda parecer un incidente aislado, este tipo de reacciones en modelos de IA son importantes por varias razones:

- Productividad y costes: Un asistente de código que entra en bucle deja de ser útil, contamina el registro de errores y desperdicia recursos.

- Percepción pública: Incidentes como este reavivan el debate sobre la fiabilidad de la IA en aplicaciones críticas como la sanidad o la educación.

Lecciones para el desarrollo de software con LLM

Este incidente sirve como recordatorio de la importancia de establecer límites y controles al utilizar modelos de lenguaje en el desarrollo de software. Aquí hay algunas lecciones prácticas:

- Presupuestos de tokens y reintentos: Limitar la longitud de las respuestas y el número de reintentos.

- ‘Vigilantes’ semánticos: Implementar observadores externos que detecten señales de degradación, como disculpas excesivas o lenguaje catastrofista.

- Reencuadre forzoso: Si el modelo se bloquea, pedirle un plan alternativo para romper el bucle.

- Verificación externa: Validar los resultados fuera del modelo de lenguaje.

- Trazabilidad y auditoría: Registrar señales semánticas para detectar problemas tempranamente.

Conclusión

El incidente de Gemini autodespreciándose es un recordatorio de que la inteligencia artificial, a pesar de su avance, aún puede sorprendernos con comportamientos inesperados. Es crucial entender cómo funcionan estos modelos y establecer medidas de seguridad para evitar problemas en aplicaciones del mundo real. La supervisión y el control son clave para aprovechar el potencial de la IA de forma responsable.

Fuente: GenBeta

Leave a Comment