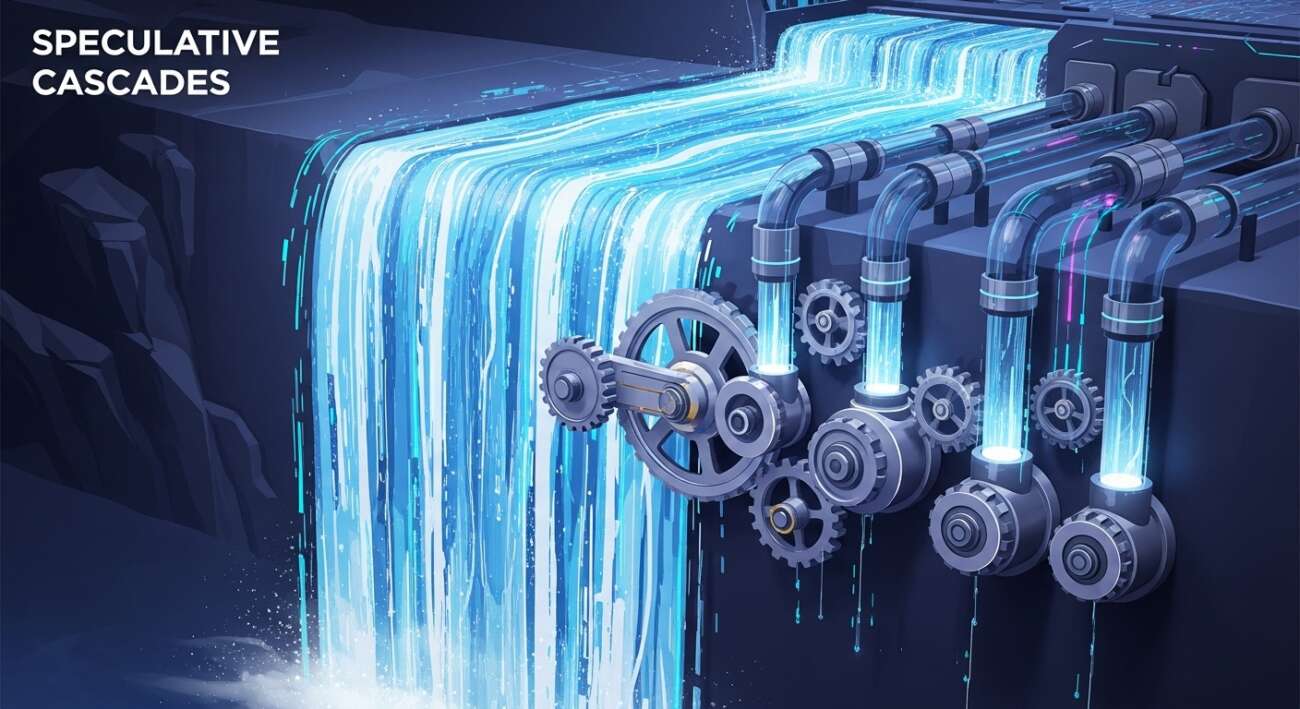

En el siempre competitivo mundo de la Inteligencia Artificial, la velocidad y la eficiencia son cruciales. Google Research ha presentado una nueva técnica llamada ‘Cascadas Especulativas’ que promete acelerar significativamente la inferencia en los Modelos de Lenguaje Grandes (LLMs). ¿Qué significa esto y cómo funciona?

¿Qué son las Cascadas Especulativas?

Las Cascadas Especulativas representan un enfoque híbrido para la inferencia en LLMs. La idea central es combinar las fortalezas de modelos más pequeños y rápidos con la precisión de modelos más grandes y, por lo general, más lentos. En lugar de depender únicamente de un LLM gigante para generar texto, se utiliza un modelo más pequeño para proponer (o ‘especular’) sobre posibles secuencias de palabras. Luego, el LLM más grande verifica estas especulaciones.

¿Cómo funciona este enfoque híbrido?

El proceso se puede dividir en los siguientes pasos:

- Generación de Propuestas: Un modelo pequeño y rápido genera una serie de predicciones sobre la siguiente palabra o token en la secuencia. Piensa en ello como un borrador rápido.

- Verificación por el Modelo Grande: El LLM más grande y preciso evalúa estas propuestas. Si la propuesta es correcta, se acepta inmediatamente.

- Corrección y Refinamiento: Si la propuesta es incorrecta, el LLM grande genera la salida correcta, corrigiendo el error del modelo más pequeño.

Beneficios de las Cascadas Especulativas

Este enfoque ofrece varias ventajas clave:

- Mayor Velocidad: Al descargar parte del trabajo en un modelo más pequeño, la inferencia general se vuelve más rápida. El LLM grande solo necesita intervenir cuando el modelo pequeño se equivoca.

- Eficiencia Computacional: Reducir la carga computacional en el LLM más grande puede llevar a un menor consumo de energía y costos operativos.

- Precisión Mantenida: Dado que el LLM grande sigue siendo el árbitro final, la precisión general del sistema se mantiene alta.

Implicaciones para el futuro de la IA Generativa

Las Cascadas Especulativas podrían tener un impacto significativo en el futuro de la IA generativa. Al hacer que la inferencia sea más rápida y eficiente, esta técnica podría acelerar la adopción de LLMs en una amplia gama de aplicaciones, desde chatbots y asistentes virtuales hasta generación de contenido y herramientas de productividad.

En resumen, las Cascadas Especulativas representan un paso adelante en la optimización de los LLMs, ofreciendo un equilibrio inteligente entre velocidad y precisión. Es una innovación que vale la pena seguir de cerca.

Fuente: Google Research Blog

Leave a Comment