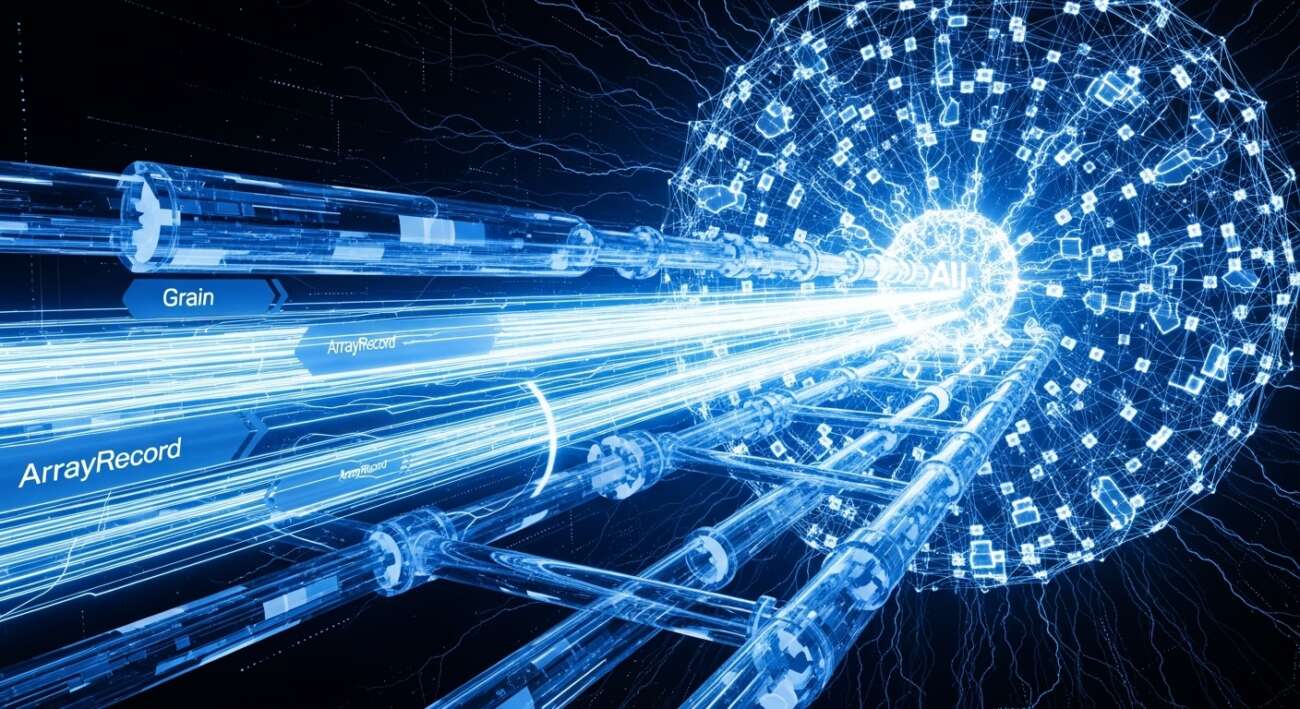

En el mundo del machine learning, entrenar modelos a gran escala requiere una cantidad masiva de datos. Sin embargo, la velocidad a la que estos datos pueden ser procesados y alimentados a los modelos a menudo se convierte en un cuello de botella, limitando el rendimiento general. Afortunadamente, existen herramientas como Grain y ArrayRecord que están diseñadas para construir pipelines de datos de alto rendimiento y superar estas limitaciones.

¿Qué son Grain y ArrayRecord?

Aunque la información original no profundiza en detalles técnicos, podemos inferir que Grain y ArrayRecord son probablemente bibliotecas o formatos de datos optimizados para la lectura y manipulación eficiente de grandes conjuntos de datos. Están pensados para trabajar en conjunto, permitiendo la creación de pipelines de datos robustos y escalables.

Beneficios de usar Grain y ArrayRecord

Basándonos en el contexto, los beneficios clave de adoptar Grain y ArrayRecord en tus pipelines de datos incluyen:

- Mayor rendimiento: Al optimizar la forma en que los datos son almacenados y procesados, se reduce la latencia y se aumenta la velocidad de transferencia de datos a los modelos.

- Escalabilidad: Permiten manejar conjuntos de datos extremadamente grandes sin comprometer el rendimiento.

- Eficiencia: Minimizan el uso de recursos computacionales, lo que se traduce en menores costos y mayor sostenibilidad.

¿Por qué es esto importante?

La capacidad de alimentar modelos de machine learning con datos de manera rápida y eficiente es crucial para el éxito de proyectos de inteligencia artificial a gran escala. Herramientas como Grain y ArrayRecord son esenciales para:

- Acelerar el tiempo de entrenamiento: Reduce el tiempo necesario para entrenar modelos complejos, permitiendo iteraciones más rápidas y una mejora continua.

- Desarrollar modelos más precisos: Al eliminar los cuellos de botella en el flujo de datos, se pueden utilizar conjuntos de datos más grandes y diversos, lo que conduce a modelos más robustos y precisos.

- Reducir los costos de infraestructura: La eficiencia en el procesamiento de datos se traduce en menores costos de almacenamiento y computación.

En Resumen

Si estás trabajando con grandes conjuntos de datos y buscas optimizar tus pipelines de datos para entrenar modelos de machine learning de alto rendimiento, vale la pena investigar Grain y ArrayRecord. Estas herramientas prometen eliminar los cuellos de botella y permitirte aprovechar al máximo el potencial de tus datos.

Fuente: Google Developers

Leave a Comment